Un laboratorio chino ha desvelado lo que parece ser uno de los primeros modelos de «razonamiento» de IA que rivaliza con o1 de OpenAI.

El miércoles, DeepSeek, una empresa de investigación de IA financiada por operadores cuantitativos, publicó un avance de DeepSeek-R1, que según la empresa es un modelo de razonamiento que compite con o1.

A diferencia de la mayoría de los modelos, los modelos de razonamiento se verifican a sí mismos dedicando más tiempo a considerar una pregunta o consulta. Esto les ayuda a evitar algunos de los escollos con los que suelen tropezar los modelos.

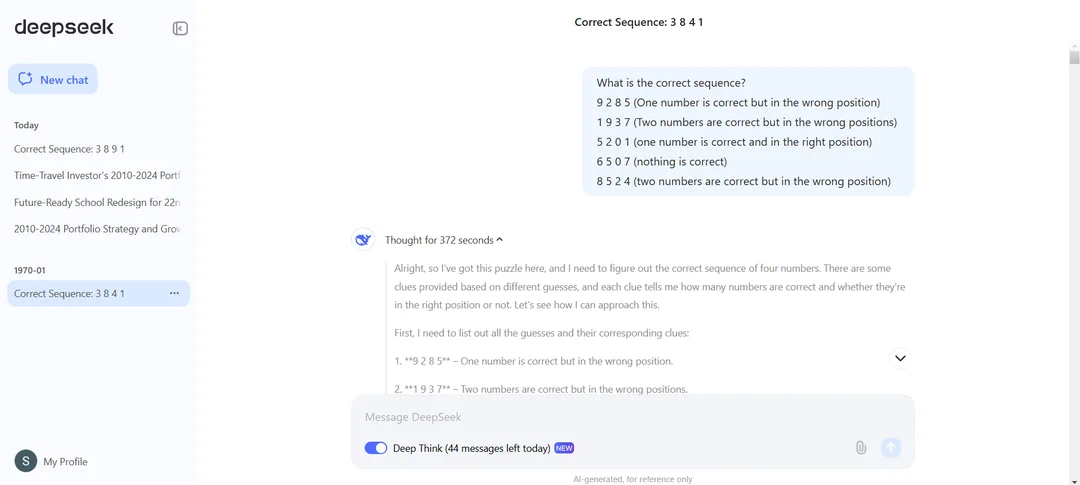

Al igual que o1, DeepSeek-R1 razona a través de tareas, planificando con antelación y realizando una serie de acciones que ayudan al modelo a llegar a una respuesta, lo que puede llevar un tiempo. Al igual que o1, dependiendo de la complejidad de la pregunta, DeepSeek-R1 puede «pensar» durante decenas de segundos antes de responder.

DeepSeek afirma que DeepSeek-R1 (o DeepSeek-R1-Lite-Preview, para ser precisos) rinde a la par que el modelo o1-preview de OpenAI en dos populares pruebas de referencia de IA, AIME y MATH. AIME utiliza otros modelos de IA para evaluar el rendimiento de un modelo, mientras que MATH es una colección de problemas de palabras. Pero el modelo no es perfecto. Algunos comentaristas de X señalaron que DeepSeek-R1 tiene problemas con el tres en raya y otros problemas lógicos (al igual que o1).

DeepSeek también puede ser fácilmente «jailbroken», es decir, programado de tal forma que se produzca cierta fuga de información que no debería proporcionar. Un usuario de X consiguió que el modelo diera una receta detallada de metanfetamina.

DeepSeek-R1 parece bloquear las consultas consideradas demasiado sensibles desde el punto de vista político. En nuestras pruebas, el modelo se negó a responder preguntas sobre el líder chino Xi Jinping, la plaza de Tiananmen y las implicaciones geopolíticas de la invasión china de Taiwán.

Es probable que este comportamiento se deba a la presión del gobierno chino sobre los proyectos de IA en la región. En China, los modelos deben someterse a una evaluación comparativa por parte del regulador chino de Internet para garantizar que sus respuestas «encarnan los valores socialistas fundamentales». Al parecer, el gobierno ha llegado incluso a proponer una lista negra de fuentes que no pueden utilizarse para entrenar modelos, lo que hace que muchos sistemas chinos de IA se nieguen a responder a temas que podrían despertar la ira de los reguladores.

Esta mayor atención a los modelos de razonamiento se produce en un momento en el que la viabilidad de las «leyes de escalado», teorías sostenidas durante mucho tiempo según las cuales la introducción de más datos y potencia de cálculo en un modelo aumentaría continuamente sus capacidades, está siendo sometida a escrutinio. Una avalancha de informes de prensa sugiere que los modelos de los principales laboratorios de IA, como OpenAI, Google y Anthropic, no están mejorando tan drásticamente como antes.

Esto ha provocado una lucha por nuevos enfoques, arquitecturas y técnicas de desarrollo de la IA. Una de ellas es la computación en tiempo de prueba, en la que se basan modelos como o1 y DeepSeek-R1. También conocida como computación de inferencia, la computación en tiempo de prueba proporciona a los modelos un tiempo de procesamiento adicional para completar las tareas.

«Estamos asistiendo a la aparición de una nueva ley de escalado», afirmó esta semana Satya Nadella, consejero delegado de Microsoft, durante un discurso pronunciado en la conferencia Ignite de Microsoft, en referencia a la computación en tiempo de prueba.

DeepSeek, que tiene previsto desarrollar DeepSeek-R1 en código abierto y publicar una API, es una operación curiosa. Está respaldada por High-Flyer Capital Management, un fondo de cobertura cuantitativo chino que utiliza la IA para fundamentar sus decisiones comerciales.

Uno de los primeros modelos de DeepSeek, un modelo de análisis de texto e imágenes de uso general llamado DeepSeek-V2, obligó a competidores como ByteDance, Baidu y Alibaba a reducir los precios de uso de algunos de sus modelos y a hacer otros completamente gratuitos.

High-Flyer construye sus propios clusters de servidores para el entrenamiento de modelos, el más reciente de los cuales cuenta con 10.000 GPU Nvidia A100 y costó 1.000 millones de yenes (~138 millones de dólares). Fundada por Liang Wenfeng, licenciado en informática, High-Flyer aspira a conseguir una IA «superinteligente» a través de su DeepSeek.org.