Cerebras Systems quiere desafiar a Nvidia utilizando sus propios procesadores que, según afirma, ejecutarán las cargas de trabajo de IA más rápido y de forma mucho más barata.

Una empresa estadounidense quiere desafiar el dominio de Nvidia en el mercado de las GPU de IA utilizando sus propios chips para ejecutar cargas de trabajo de IA de forma más rápida y barata.

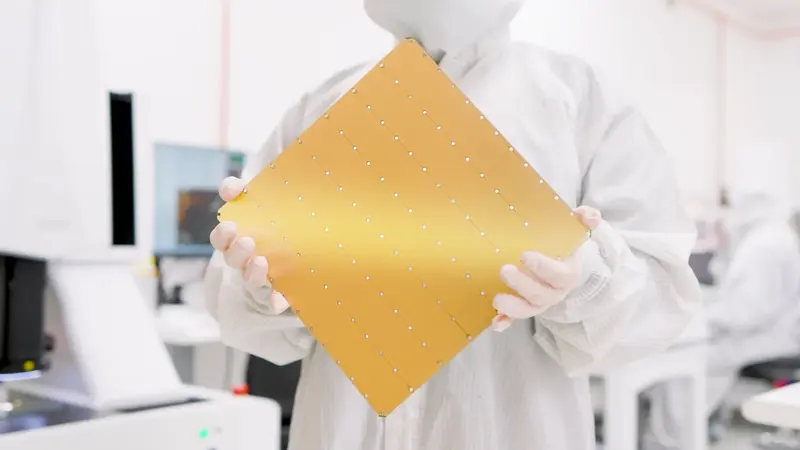

Se trata de Cerebras Systems, que ha estado desarrollando procesadores del tamaño de un iPad denominados Wafer Scale Engine. El martes anunció un servicio que permitirá a los clientes utilizar sus chips para sus propios programas de IA. La principal diferencia es que Cerebras afirma que su tecnología puede ejecutar programas de IA generativa hasta 20 veces más rápido, pero a una quinta parte del coste de las GPU de Nvidia, como la H100, un procesador de IA muy utilizado en el sector.

Denominado Cerebras Inference, el servicio se refiere a la capacidad de un programa de IA para generar nuevos datos, como predecir la siguiente palabra al escribir un texto. Cerebras afirma que su propia plataforma es la «solución de inferencia de IA más rápida del mundo». Para demostrarlo, la empresa está utilizando chips Wafer Scale Engine para alimentar el modelo de gran lenguaje de código abierto Llama 3.1 de Meta. Los resultados pueden hacer que Llama 3.1 proporcione respuestas aparentemente sin retraso.

Introducing Cerebras Inference

‣ Llama3.1-70B at 450 tokens/s – 20x faster than GPUs

‣ 60c per M tokens – a fifth the price of hyperscalers

‣ Full 16-bit precision for full model accuracy

‣ Generous rate limits for devs

Try now: https://t.co/50vsHCl8LM pic.twitter.com/hD2TBmzAkw— Cerebras (@CerebrasSystems) August 27, 2024

En concreto, Cerebras afirma que sus chips pueden ejecutar la versión de 8.000 millones de parámetros de Llama 3.1 para producir 1.800 tokens por segundo, cada uno de los cuales representa unos cuatro caracteres de la lengua inglesa. En otras palabras, el programa de IA puede producir un artículo de 1.300 palabras en un segundo.

Los mismos chips también pueden ejecutar la versión más potente de Llama 3.1, con 70.000 millones de parámetros, para producir 450 tokens por segundo. En ambas pruebas, Cerebras afirma que su tecnología supera con creces el rendimiento de tokens por segundo de los proveedores de IA en la nube, como AWS de Amazon, Microsoft Azure y Groq.

La creación de servicios de chatbot en torno a la implementación de Cerebra de Llama 3.1 también promete ser barata, según la startup. «Cerebra Inference tiene un precio muy inferior al de sus competidores basados en GPU, con precios de pago por uso de 10 céntimos por millón de tokens para Llama 3.1 8B y de 60 céntimos por millón de tokens para Llama 3.1 70B». En cambio, OpenAI, desarrollador de ChatGPT y usuario de chips Nvidia, puede cobrar a terceras empresas entre 2,50 y 15 dólares por un millón de tokens.

Cerebras ha estado fabricando sus chips Wafer Scale Engine con la taiwanesa TSMC, el fabricante de chips por contrato que está detrás de las GPU de IA de Nvidia. En marzo, Cerebras presentó el chip de tercera generación, el WSE-3, que cuenta con 4 billones de transistores y 900.000 núcleos de IA.

En una entrada de su blog, la startup también arremetía contra Nvidia afirmando que el WSE-3 de la compañía ofrece 7.000 veces más ancho de banda de memoria que el H100. «Cerebras resuelve el cuello de botella del ancho de banda de la memoria construyendo el chip más grande del mundo y almacenando todo el modelo en el chip. Un Wafer Scale Engine tiene 44 GB de SRAM en el chip», añadió la startup en un tuit.

Aun así, Cerebras está comparando el WSE-3 con la tecnología más antigua de Nvidia, teniendo en cuenta que el H100 se lanzó por primera vez en 2022. En marzo, Nvidia presentó su sucesor, la arquitectura Blackwell, que promete mejorar el rendimiento de la H100 entre siete y treinta veces. La compañía planea comercializar Blackwell a través de los nuevos productos GB200 y B200 a finales de este año, aunque The Information informa de que las GPU podrían retrasarse tres meses.

Nvidia no respondió de inmediato a la solicitud de comentarios. Mientras tanto, Cerebras está intentando ampliar el acceso a su chip WSE-3. Esto incluye poner el silicio a disposición de otros proveedores de nube. Pero no es de extrañar que el chip de IA de la empresa no sea barato. Cerebras explicó que vende el WSE-3 a través de su oferta de hardware CS-3, que cuesta «un par de millones por sistema». Eso es bastante más caro que una sola GPU H100, que puede rondar los 30.000 dólares.